GPT-4 দ্বারা উপস্থাপিত বড় মডেলগুলি মস্তিষ্ক তৈরি করেছে এবং পরবর্তী ধাপে একটি রোবট বডি প্রয়োজন যা এই মস্তিষ্ক বহন করতে পারে।

গতরাতে, হিউম্যানয়েড রোবট তারকা সংস্থা ফিগার এআই চমকপ্রদভাবে একটি ভিডিও প্রকাশ করেছে যেটি ওপেনএআই-এর শক্তিশালী মডেলের সমর্থনে তাদের রোবট চিত্র 01 দ্বারা সম্পাদিত কথোপকথনের একটি সিরিজ দেখানো হয়েছে।

ভিডিওতে রোবটটি নমনীয় অপারেটিং প্রতিক্রিয়া দেখায় এবং মানুষের সাথে যোগাযোগের ক্ষেত্রে এর সাবলীলতা বাস্তব মানুষের সাথে প্রায় তুলনীয়।

ওপেনএআই, মাইক্রোসফ্ট, এনভিআইডিআইএ এবং অন্যান্য কোম্পানির কাছ থেকে ফিগার এআই বিনিয়োগ পাওয়ার পর এটি অর্ধেকেরও কম। এটি আমাকে ওপেনএআই-এর সবচেয়ে শক্তিশালী মাল্টি-মোডাল বড় মডেলটি শরীরের সাথে দেখতে কেমন হবে তা দেখতে দেয়।

চিত্র 01, হিউম্যানয়েড রোবট যে আপনাকে সবচেয়ে ভালো বোঝে?

OpenAI এর মাল্টি-মোডাল বড় মডেলের শক্তিশালী সমর্থনের জন্য ধন্যবাদ, চিত্র 01 এখন টেবিলে বস্তুর স্বীকৃতিতে বিশেষজ্ঞ। আপেল, ড্রেনার, কাপ এবং প্লেট সবই এর জন্য কেকের টুকরো!

আপনি যখন ক্ষুধার্ত হবেন এবং আপনি এটি পুরো মুখে খেতে চান, এটি তাত্ক্ষণিকভাবে আপনার চিন্তাগুলি বুঝতে পারবে এবং আপনাকে একটি আপেল দিয়ে দেবে।

তাছাড়া, এটি এমনকি আপনার ফেলে দেওয়া আবর্জনা তুলে নিতে পারে এবং আপনাকে ব্যাখ্যা করতে পারে কেন এটি আপনাকে আপেল দিয়েছে। বড় মডেলের সাহায্যে, চিত্র 01 টেবিলের একমাত্র খাবার বুঝতে পারে – আপেল।

একজন মানুষের নির্দেশে, চিত্র 01 ঘরের কাজও করতে পারে এবং থালা-বাসনও ফেলে দিতে পারে৷ এই রোবটটি কেবল পারিবারিক জীবনের সেরা অংশীদার৷

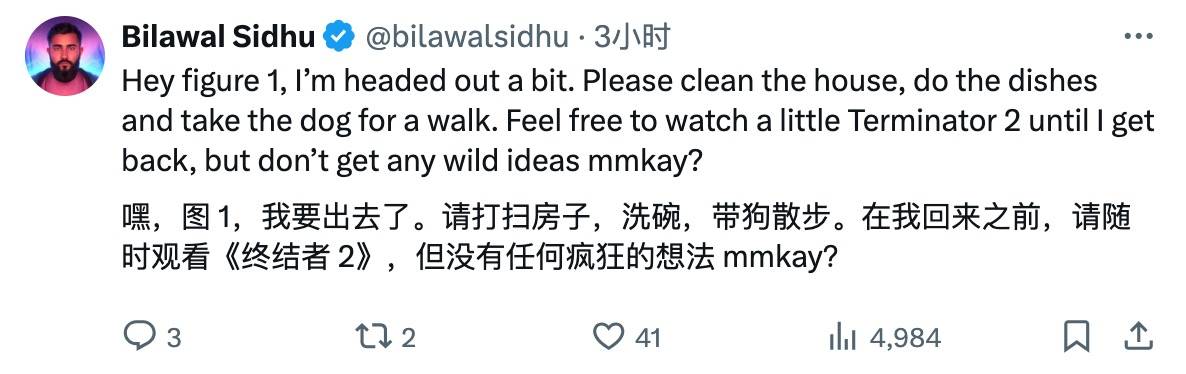

এই চমকপ্রদ ভিডিও দেখার পর নেটিজেনদের নানা রকম প্রতিক্রিয়া দেখা দিয়েছে।

নেটিজেনরা চিত্র 01-এ কাজগুলি অর্পণ করার জন্য অপেক্ষা করতে পারে না। কীভাবে রোবট পূর্বসূরীদের সম্পর্কে চলচ্চিত্রগুলি টাস্ক তালিকায় মিশ্রিত হয়েছে।

প্রতিযোগীরা কি এটি দেখে ভয় পাচ্ছে, তাদের হৃদয়ে উদ্বিগ্ন, গোপনে একটি বড় প্রযুক্তিগত প্রতিযোগিতার জন্য প্রস্তুতি নিচ্ছে?

আরও উচ্ছ্বসিত নেটিজেনরা বলেছেন যে AGI-এর ভোর ঠিক কোণার কাছাকাছি বলে মনে হচ্ছে।

অবশ্যই, কিছু সমালোচনামূলক কণ্ঠ সবসময় আছে। কিছু নেটিজেন অভিযোগ করেছেন, কেন এই রোবট ঝাঁকুনি দিচ্ছে?

নেটিজেনরাও রসিকতা করার সুযোগ হাতছাড়া করেননি।

ব্রেট অ্যাডক, চিত্র এআই-এর প্রধান, একা থাকতে ইচ্ছুক ছিলেন না এবং একটি চমৎকার ব্যাখ্যা দেওয়ার জন্য X-এ ঝাঁপিয়ে পড়েন।

ভিডিওটি এন্ড-টু-এন্ড নিউরাল নেটওয়ার্কের প্রয়োগ প্রদর্শন করে। এই প্রক্রিয়া চলাকালীন কোন রিমোট কন্ট্রোল (টেলিওপ) ব্যবহার করা হয় না। ভিডিওটি প্রকৃত গতিতে (1.0x গতি) শট করা হয়েছে এবং অবিচ্ছিন্ন।

আপনি ভিডিওতে দেখতে পাচ্ছেন, রোবটগুলির গতি উল্লেখযোগ্যভাবে উন্নত হয়েছে এবং আমরা ধীরে ধীরে মানুষের মতো গতিতে পৌঁছে যাচ্ছি।

কোন রিমোট কন্ট্রোলের প্রয়োজন নেই, স্ব-শিক্ষিত

তাহলে কিভাবে চিত্র 01 এটা করে?

চিত্র এআই দলের নেতা কোরি লিঞ্চ এক্স-এ এটি ব্যাখ্যা করেছেন।

বিশেষত, ভিডিওতে প্রদর্শিত সমস্ত আচরণ শেখা হয়েছিল (দূরবর্তীভাবে নিয়ন্ত্রিত নয়) এবং বাস্তবসম্মত গতিতে (1.0x গতি) সঞ্চালিত হয়েছিল।

ফিগার AI রোবটের ক্যামেরা দ্বারা ধারণ করা ছবি এবং অনবোর্ড মাইক্রোফোনের মাধ্যমে রেকর্ড করা ভয়েস-ট্রান্সক্রাইবড টেক্সটকে OpenAI দ্বারা প্রশিক্ষিত একটি মাল্টিমোডাল মডেলে ফিড করে যা ইমেজ এবং টেক্সট তথ্য উভয়ই বুঝতে পারে।

একটি মৌখিক প্রতিক্রিয়া তৈরি করতে এবং টেক্সট-টু-স্পিচের মাধ্যমে মানুষের সাথে কথা বলার জন্য মডেলটি অতীতের ছবি সহ পুরো কথোপকথনের ইতিহাস প্রক্রিয়া করে। প্রদত্ত কমান্ডের প্রতিক্রিয়ায় কোনটি শিখেছে ক্লোজড-লুপ আচরণ চালানো হবে তা সিদ্ধান্ত নেওয়ার জন্যও একই মডেল দায়ী৷ এটি GPU-তে নির্দিষ্ট নিউরাল নেটওয়ার্ক ওজন লোড করে এবং সংশ্লিষ্ট নীতি কার্যকর করে৷

চিত্র 01 কে একটি বৃহৎ প্রাক-প্রশিক্ষিত মাল্টি-মোডাল মডেলের সাথে সংযুক্ত করা এতে অনেক আকর্ষণীয় নতুন বৈশিষ্ট্য নিয়ে আসে।

এখন, চিত্র 01 + OpenAI করতে পারে:

- তার চারপাশের বিস্তারিত।

- সিদ্ধান্ত নেওয়ার সময় সাধারণ জ্ঞানের যুক্তি ব্যবহার করুন। উদাহরণস্বরূপ, "টেবিলের আইটেমগুলি, সেই প্লেট এবং কাপের মতো, সম্ভবত পরবর্তী শুকানোর র্যাকে রাখা হবে।"

- অস্পষ্ট উচ্চ-স্তরের নির্দেশাবলী, যেমন "আমি ক্ষুধার্ত", পরিস্থিতিগতভাবে উপযুক্ত আচরণে রূপান্তর করুন, যেমন "সেই ব্যক্তিকে একটি আপেল দিন।"

- সরল ইংরেজিতে ব্যাখ্যা করুন কেন এটি একটি নির্দিষ্ট ক্রিয়া সম্পাদন করে। উদাহরণস্বরূপ, "এটি একমাত্র ভোজ্য আইটেম যা আমি টেবিল থেকে অফার করতে পারি।"

যখন চিত্র 01 শেখার মাধ্যমে আয়ত্ত করা সূক্ষ্ম হ্যান্ডস-অন দক্ষতার কথা আসে, আসলে এর পিছনে রয়েছে জটিল এবং সূক্ষ্ম নীতিগুলির একটি সিরিজ।

সমস্ত আচরণ নিউরাল নেটওয়ার্কের দৃষ্টি-থেকে-মোটর রূপান্তরকারী কৌশল দ্বারা চালিত হয়, যা সরাসরি চিত্রের পিক্সেলকে কর্মের সাথে মানচিত্র করে। এই নেটওয়ার্কগুলি প্রতি সেকেন্ডে 10 ফ্রেম হারে রোবটে নির্মিত ছবিগুলি গ্রহণ করে এবং প্রতি সেকেন্ডে 200 বার 200 24-ডিগ্রি-অফ-ফ্রিডম মোশন (কব্জির ভঙ্গি এবং আঙুলের জয়েন্ট অ্যাঙ্গেল সহ) তৈরি করে।

এই আন্দোলনগুলি উচ্চ-গতির পূর্ণ-বডি কন্ট্রোলার দ্বারা ট্র্যাক করার জন্য উচ্চ-গতির "সেট পয়েন্ট" হিসাবে কাজ করে, আন্দোলনগুলির সুনির্দিষ্ট সম্পাদন নিশ্চিত করে।

এই নকশাটি উদ্বেগের কার্যকর বিচ্ছেদ অর্জন করে:

- ইন্টারনেট প্রাক-প্রশিক্ষিত মডেলগুলি একটি উচ্চ-স্তরের পরিকল্পনা তৈরি করতে চিত্র এবং পাঠ্যের উপর সাধারণ জ্ঞানের যুক্তি প্রদর্শন করে।

- শেখা ভিসুও-মোটর কৌশল এই পরিকল্পনাটি কার্যকর করে, দ্রুত, প্রতিক্রিয়াশীল আচরণগুলি সম্পাদন করে যা ম্যানুয়ালি নির্দিষ্ট করা কঠিন, যেমন যে কোনও অবস্থানে একটি বিকৃত ব্যাগ পরিচালনা করা।

- একই সময়ে, পূর্ণ-বডি নিয়ামক আন্দোলনের নিরাপত্তা এবং স্থিতিশীলতা নিশ্চিত করার জন্য দায়ী, উদাহরণস্বরূপ, রোবটের ভারসাম্য বজায় রাখা।

চিত্র 01 দ্বারা তৈরি দুর্দান্ত অগ্রগতি সম্পর্কে, কোরি লিঞ্চ দুঃখ প্রকাশ করেছেন:

মাত্র কয়েক বছর আগে, আমি ভেবেছিলাম যে স্বায়ত্তশাসিতভাবে পরিকল্পনা করতে এবং শেখা আচরণগুলি সম্পাদন করতে সক্ষম একটি হিউম্যানয়েড রোবটের সাথে সম্পূর্ণ কথোপকথন ভবিষ্যতে কয়েক দশক হবে। স্পষ্টতই, অনেক কিছু নাটকীয়ভাবে পরিবর্তিত হয়েছে।

এটি কি মানবিক রোবটের জিপিটি মুহূর্ত হতে পারে?

এটা বলতে হবে যে চিত্র 01-এর বিকাশের গতি হল অ্যাক্সিলারেটরে পা রাখা এবং সমস্ত পথে দৌড়ানোর মতো।

এই বছরের জানুয়ারিতে, চিত্র 01 কফি তৈরির দক্ষতা আয়ত্ত করেছে। এই কৃতিত্ব একটি এন্ড-টু-এন্ড নিউরাল নেটওয়ার্কের প্রবর্তনের কারণে, যা রোবটকে শুধুমাত্র 10 ঘন্টার প্রশিক্ষণের মাধ্যমে স্বায়ত্তশাসিতভাবে শিখতে এবং ত্রুটিগুলি সংশোধন করার অনুমতি দেয়।

এক মাস পরে, চিত্র 01 মানুষের গতি মাত্র 16.7% হলেও বাক্সগুলিকে উত্তোলন এবং একটি পরিবাহক বেল্টে পৌঁছে দেওয়ার নতুন দক্ষতা শিখেছিল।

এই প্রক্রিয়া চলাকালীন, চিত্র AI এর বাণিজ্যিকীকরণের গতি থেমে যায়নি। এটি অটোমোবাইল উত্পাদন লাইনে AI এবং রোবোটিক্স প্রযুক্তিকে একীভূত করার জন্য BMW উত্পাদনকারী কোম্পানির সাথে একটি বাণিজ্যিক চুক্তি স্বাক্ষর করেছে এবং BMW-এর কারখানায় বসতি স্থাপন করেছে।

তারপরে, মাত্র দুই সপ্তাহ আগে, ফিগার একটি $675 মিলিয়ন সিরিজ বি রাউন্ডের অর্থায়নের সমাপ্তির ঘোষণা করেছিল, কোম্পানির মূল্যায়ন $2.6 বিলিয়নে বেড়েছে।

বিনিয়োগকারীরা সিলিকন ভ্যালির প্রায় অর্ধেক কভার করে – মাইক্রোসফ্ট, ওপেনএআই ভেঞ্চার ফান্ড, এনভিআইডিএ, জেফ বেজোস, পার্কওয়ে ভেঞ্চার ক্যাপিটাল, ইন্টেল ক্যাপিটাল এবং অ্যালাইন ভেঞ্চার ইত্যাদি।

সেই সময়ে, ওপেনএআই এবং ফিগারও ঘোষণা করেছিল যে তারা যৌথভাবে পরবর্তী প্রজন্মের হিউম্যানয়েড রোবট এআই মডেল তৈরি করবে।ওপেনএআই-এর মাল্টি-মডেল মডেলটি রোবট উপলব্ধি, যুক্তি এবং মিথস্ক্রিয়াতে প্রসারিত হবে।

এখন, চিত্র 01 থেকে, আমরা ভবিষ্যতের জীবনের একটি খসড়া আভাস দিতে সক্ষম বলে মনে হচ্ছে।

প্রকৃতপক্ষে, বড় মডেলের আগে, রোবটগুলি বিশেষ সরঞ্জাম ছিল। এখন বড় মডেলগুলির সাধারণ ক্ষমতার সাথে সাধারণ রোবটগুলি উপস্থিত হতে শুরু করেছে। এখন আমাদের কেবল চ্যাটজিপিটি নয়, ওয়ার্কজিপিটিও দরকার।

এই বিবর্তনগুলি পরোক্ষভাবে একটি স্পষ্টভাবে দৃশ্যমান পথ নিশ্চিত করে: বৃহৎ এআই মডেল রুট হওয়ার পরে, এটি অবশেষে বাস্তব জগতে প্রবেশ করবে এবং মূর্ত বুদ্ধিমত্তা হল সর্বোত্তম পথ।

এনভিডিয়ার প্রতিষ্ঠাতা জেনসেন হুয়াং, যিনি এআই-এর সামনের সারিতে সক্রিয় ছিলেন, একবার বলেছিলেন: "মূর্ত বুদ্ধিমত্তা কৃত্রিম বুদ্ধিমত্তার পরবর্তী তরঙ্গের নেতৃত্ব দেবে।"

চিত্র 01-এ বড় ওপেনএআই মডেলকে একীভূত করাও একটি ইচ্ছাকৃত কৌশলগত বিন্যাস।

পরিপক্ক AI বড় মডেলগুলি কৃত্রিম মস্তিষ্ক হিসাবে কাজ করে, মানব মস্তিষ্কের জটিল নিউরাল নেটওয়ার্ককে অনুকরণ করে, ভাষা বোঝা, চাক্ষুষ স্বীকৃতি, এবং পরিস্থিতিগত যুক্তির মতো জ্ঞানীয় কাজগুলি উপলব্ধি করে এবং রোবটের জন্য উচ্চ-স্তরের জ্ঞানীয় এবং সিদ্ধান্ত গ্রহণের সমস্যাগুলি সমাধান করে।

একই সময়ে, পরিবেশের সাথে উপলব্ধি এবং মিথস্ক্রিয়া উপলব্ধি করার জন্য বিভিন্ন সেন্সর, অ্যাকচুয়েটর এবং কম্পিউটিং ইউনিটগুলি রোবট বডিতে একত্রিত হয়। উদাহরণস্বরূপ, দৃষ্টি সিস্টেমগুলি ছবি এবং ভিডিওগুলি ক্যাপচার করতে পারে এবং স্পর্শকাতর সেন্সরগুলি বস্তুর আকৃতি এবং টেক্সচার বুঝতে পারে।

Figure AI এর প্রতিষ্ঠাতা ব্রেট অ্যাডকক পূর্বে একটি সাক্ষাত্কারে বলেছিলেন যে আগামী 1-2 বছরে, Figure AI ল্যান্ডমার্ক পণ্যগুলির উন্নয়নে মনোনিবেশ করবে এবং আগামী এক বা দুই বছরে জনসাধারণের কাছে হিউম্যানয়েড রোবটগুলির গবেষণা এবং উন্নয়ন ফলাফল প্রদর্শন করবে বলে আশা করছে, AI সিস্টেম, নিম্ন-স্তরের নিয়ন্ত্রণ ইত্যাদি কভার করে এবং অবশেষে একটি রোবট আবির্ভূত হয় যা দৈনন্দিন জীবনে তার প্রতিভা দেখাতে পারে।

তিনি আরও প্রকাশ করেছেন যে খরচের দিক থেকে, একটি হিউম্যানয়েড রোবটের প্রায় 1,000 যন্ত্রাংশ রয়েছে এবং তার ওজন প্রায় 150 পাউন্ড (68 কেজি), যখন একটি বৈদ্যুতিক গাড়ির প্রায় 10,000 যন্ত্রাংশ থাকতে পারে এবং 4,000-5,000 পাউন্ড (1,800-2,250 কেজি) ওজনের হতে পারে। অতএব, দীর্ঘমেয়াদে, হিউম্যানয়েড রোবটগুলির খরচ সস্তা বৈদ্যুতিক গাড়ির তুলনায় কম হবে বলে আশা করা হচ্ছে, অ্যাকুয়েটর, মোটর উপাদান, সেন্সর এবং কম্পিউটিং খরচের উপর নির্ভর করে।

রোবট বিশেষজ্ঞ এরিক জ্যাং একবার তার অন্তর্দৃষ্টি সামনে রেখেছিলেন: "যদিও অনেক AI গবেষক বিশ্বাস করেন যে সর্বজনীন রোবট জনপ্রিয় হতে কয়েক দশক সময় লাগবে, ভুলে যাবেন না যে চ্যাটজিপিটি প্রায় রাতারাতি জন্ম নিয়েছে।"

আজ থেকে এক বছর আগে, ওপেনএআই GPT-4 প্রকাশ করেছে, বিশ্বের কাছে বড় মডেলের শক্তি প্রমাণ করেছে।

আজ, এক বছর পরে, আমরা GPT-5-এর জন্য অপেক্ষা করিনি, কিন্তু আমরা চিত্র 01কেও স্বাগত জানিয়েছি। মানবিক রোবটের জন্য এটি কি GPT-4 মুহূর্ত হবে?

# aifaner: aifaner (WeChat ID: ifanr) এর অফিসিয়াল WeChat পাবলিক অ্যাকাউন্ট অনুসরণ করতে স্বাগতম। যত তাড়াতাড়ি সম্ভব আপনাকে আরও উত্তেজনাপূর্ণ সামগ্রী সরবরাহ করা হবে।